12个python超强学习网站

淘宝搜:【红包到手500】领超级红包,京东搜:【红包到手500】

淘宝互助,淘宝双11微信互助群关注公众号 【淘姐妹】

目录前言进程介绍和查询进程基本介绍显示系统执行的进程终止进程服务管理监控服务动态监控进程监控网络状态结语前言 本篇博客总结linux中的进程管理相关知识,主要有进程介绍,终止进程,服务管理以及监控服务,一起来看看吧&#x…...

🏆今日学习目标:抽象类和接口 😃创作者:颜颜yan_ ?个人主页:颜颜yan_的个人主页 ?本期期数:第二期 🎉专栏系列:JAVA 文章目录一、抽象类抽象类的定义规则示例二、接口接口定义与语…...

FastAPI 接收文件上传 文章目录FastAPI 接收文件上传一、bytes 方式1、接受单个 bytes 数据修改 files 格式2、接收多个 bytes 文件二、UploadFile 格式接收文件1、接收单个文件2、接收多个文件3、多个参数接收文件三、通过网页上传文件本文主要测试使用 FastAPI 编写接收文件的…...

一.主要是在textarea(antd的TextArea组件也可以这么使用)参数中加上【【微信】】参数和onKeyDown参数: 【【微信】】d{rtnTxtDisabled} onKeyDown{e > { const targetStr preRtnTxt; const endIdx targetStr.length; …...

前言 很高兴遇见你~ 最近打开各大 App 会发现它们都做了黑白化,如下支付宝的处理: 可以看到应用设置了全局灰色调,表达了一种对逝者的哀悼,非常的应景和人性化。作为程序猿,我们来探索一下它从技术角度是怎么实现的。…...

上一节结尾给你留的一个思考题是,你知道怎么查看 IP 地址吗? 当面试听到这个问题的时候,面试者常常会觉得走错了房间。我面试的是技术岗位啊,怎么问这么简单的问题? 的确,即便没有专业学过计算机的人,只要倒腾过电脑,重装过系统,大多也会知道这个问题的答案:在 Win…...

随着构建次数过多,之后jenkins构建会出现空间不足的问题,解决方式如下: 目录 1.配置时,去除旧的构建任务 2.使用脚本,删除历史构建 3.清理磁盘空间 4.重新加载服务器节点 1.配置时,去除旧的构建任务 2…...

全网惟一面向软件测试人员的Python基础教程 起点:《python软件测试实战宝典》介绍 第一章 为什么软件测试人员要学习Python 第二章 学Python之前要搞懂的道理 第三章 你知道Python代码是怎样运行的吗? 第四章 Python数据类型中有那些故事呢?…...

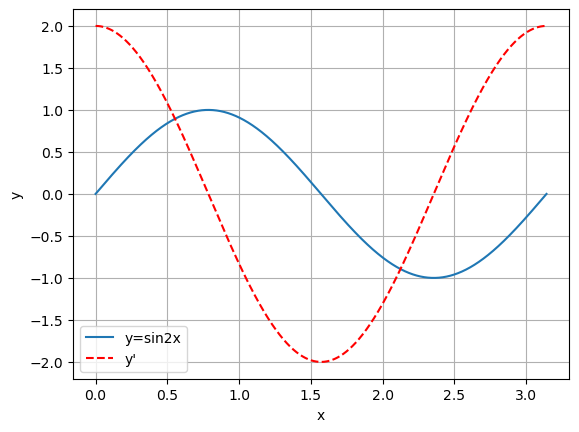

pytorch 的自动求导功能简介一、反向传播算法简介二、pytorch 的自动求导功能1. 前言2. 我们需要自动求导机制做什么3. 一个简单的例子4. 模型训练过程中使用自动求导(略)5. 关闭和打开自动求导6. 自动求导和原地替换操作7. 自动求导的性能分析器(略)8. 高阶话题:关…...

近日,由清华技术成果转化的公司智谱AI 开源了 GLM 系列模型的新成员――中英双语对话模型 【【微信】】,支持在单张消费级显卡上进行推理使用。这是继此前开源 GLM-130B 千亿基座模型之后,智谱AI 再次推出大模型方向的研究成果。与此同时,基于千亿基座模型的 ChatGLM 也同期推出,初具问答和对话功能,现已开启邀请制内测(内测申请网址 【【网址】】),后续还会逐步扩大内测范围。

据悉,【【微信】】 是一个开源的、支持中英双语问答的对话语言模型,并针对中文进行了优化。该模型基于 General Language Model(GLM)架构,具有 62 亿参数。结合模型量化技术,用户可以在消费级的显卡上进行本地部署(INT4 量化级别下最低只需 6GB 显存)。【【微信】】 使用了和 ChatGLM 相同的技术,针对中文问答和对话进行了优化。经过约 1T 标识符的中英双语训练,辅以监督微调、反馈自助、人类反馈强化学习等技术的加持,62 亿参数的 【【微信】】 虽然规模不及千亿模型,但大大降低了推理成本,提升了效率,并且已经能生成相当符合人类偏好的回答。

模型开源地址:

【【网址】】/THUDM/【【微信】】。

具体来说,【【微信】】 具备以下特点:

充分的中英双语预训练:【【微信】】 在 1:1 比例的中英语料上训练了 1T 的 token 量,兼具双语能力。

优化的模型架构和大小:吸取 GLM-130B 训练经验,修正了二维 RoPE 位置编码实现,使用传统 FFN 结构。6B(62亿)的参数大小,也使得研究者和个人开发者自己微调和部署 【【微信】】 成为可能。

较低的部署门槛:FP16 半精度下,【【微信】】 需要至少 13 GB 的显存进行推理,结合模型量化技术,这一需求可以进一步降低到 10GB(INT8)和 6GB(INT4),使得 【【微信】】 可以部署在消费级显卡上。

更长的序列长度:相比 GLM-10B(序列长度 1024),【【微信】】 序列长度达 2048,支持更长对话和应用。

人类意图对齐训练:使用了监督微调(【【微信】】g)、反馈自助(Feedback Bootstrap)、人类反馈强化学习(RLHF)等方式,使模型初具理解人类指令意图的能力。输出格式为 markdown,方便展示。

基于以上特点,【【微信】】 在一定条件下具备较好的对话与问答能力,以下是 【【微信】】 的对话效果展示:

不过由于 【【微信】】 模型的容量较小,不可避免的存在一些局限和不足,包括:

相对较弱的模型记忆和语言能力。在面对许多事实性知识任务时,【【微信】】 可能会生成不正确的信息,也不太擅长逻辑类问题(如数学、编程)的解答。

可能会产生有害说明或有偏见的内容:【【微信】】 只是一个初步与人类意图对齐的语言模型,可能会生成有害、有偏见的内容。

较弱的多轮对话能力:【【微信】】 的上下文理解能力还不够充分,在面对长答案生成和多轮对话的场景时,可能会出现上下文丢失和理解错误的情况。

同时,智谱AI 还开启了 ChatGLM 线上模型的内测。相比起 【【微信】】,ChatGLM 线上模型的能力提升主要来源于独特的千亿基座模型 GLM-130B。它采用了不同于 BERT、GPT-3 以及 T5 的 GLM 架构,是一个包含多目标函数的自回归预训练模型。2022 年 11 月,斯坦福大学大模型中心对全球 30 个主流大模型进行了全方位的评测,GLM-130B 是亚洲唯一入选的大模型。在与 OpenAI、Google Brain、微软、英伟达、【【微信】】 的各大模型对比中,评测报告显示 GLM-130B 在准确性和公平性指标上与 GPT-3 175B(davinci)接近或持平,鲁棒性、校准误差和无偏性优于 GPT-3 175B(如下图)。

基于千亿基座的 ChatGLM 线上模型目前在 【【网址】】 进行邀请制内测,用户需要使用邀请码进行注册,也可以填写基本信息申请内测。

由 ChatGLM 生成的对话效果展示:

整体而言,ChatGLM 距离国际顶尖大模型研究和产品还有一定差距,GLM 团队也在博客中坦言了这一点,并表示将持续研发并开源更新版本的 ChatGLM 和相关模型。欢迎大家下载 【【微信】】,基于它进行研究和(非商用)应用开发。GLM 团队希望能和开源社区研究者和开发者一起,推动大模型研究和应用在中国的发展。

博客链接请见:https://【【网址】】/blog

关于智谱AI

智谱AI由清华大学计算机系的技术成果转化而来,致力于打造新一代认知智能通用模型,提出了Model as a Service(MaaS)的市场理念。公司于2021年合作研发了双语千亿级超大规模预训练模型GLM-130B,并主导构建了高精度通用知识图谱,把两者有机融合为数据与知识双轮驱动的认知引擎,并基于此千亿基座模型打造 ChatGLM (【【网址】】)。此外,智谱AI也推出了认知大模型平台Bigmodel.ai,形成AIGC产品矩阵,包括高效率代码模型CodeGeeX、高精度文图生成模型CogView等,提供智能API服务。通过认知大模型链接物理世界的亿级用户、赋能元宇宙数字人、成为具身机器人的基座,赋予机器像人一样“思考”的能力。官网请见(【【网址】】)

|点击关注我 记得标星|

原标题:《?ChatGLM:千亿基座的对话模型启动内测,单卡版模型已全面开源》

阅读原文